Аудит сайта «на коленке»

При беглом анализе сайта можно узнать многое: когда компания вышла в интернет, продвигает ли она свой сайт и др.

Наши специалисты расскажут как провести подобный аудит всего за 3 минуты.

Определяем систему управления сайта (CMS)

У каждой Content Management System (CMS) есть свои плюсы и минусы. В качестве системы автоматического определения CMS можно использовать сервис 2ip.ru/cms/.

Для продвижения сайта seo-специалисту необходимо понимать, учитывал ли программист при разработке сайта важные SEO-правила. Как показывает практика, такие случаи редки, поэтому после сдачи проекта необходимо внедрять множество доработок по SEO. Притом неважно на какой CMS был выполнен сайт. Чтобы заранее учесть все важные SEO-правила при разработке проекта - ознакомьтесь со статьей.

Основные недостатки бесплатных CMS (Wordpress, Joomla, Drupal и др.) для SEO:

- Дублирование контента.

- Большое количество некачественных проектов из-за низкого уровня разработчиков. Отсюда проблемы с безопасностью.

Если Ваш сайт делали такие супер-герои, как специалисты SLT ^_^, то Вы не столкнетесь с болячками бесплатных CMS.

Главные недостатки коммерческих CMS (1C-Bitrix, UMI и др.) для SEO:

- Дублирование контента, например, для 1C-Bitrix дублирование часто встречается в каталожной структуре.

- Высокая стоимость поддержки и доработки. Обычно стоимость часа работы back-end специалиста по коммерческим CMS выше, чем по бесплатным. Это связано с тем, что уровень вхождения программистов для коммерческих платформ выше.

Как видно, для всех CMS (бесплатных и коммерческих) при недальновидной работе разработчиков справедливо дублирование контента. Дублирование материала по различным адресам страниц - один из «злейших врагов» успешного SEO. А это значит, что придется выделить значительные ресурсы на исправление ошибок дублирования. Если конечно их можно исправить в принципе.

Проверяем, находится ли сайт под фильтром

Разберем, какие фильтры сайтов существуют, их отличия и чем опасны они для продвижения.

- Фильтр за переоптимизацию - применяется к сайтам за наличие большого количества повторов ключевых слов, все мы помним чудесные «портянки» из текстов.

- АГС - затрагивает сайты с не уникальным контентом, дублями страниц, злоупотреблением внутренней перелинковкой, наличием большого числа внешних ссылок (сайты, сделанные для продажи ссылок). Очень редко фильтр накладывается на коммерческие сайты, если на сайте найден АГС, то с вероятностью 99% на сайте зарабатывают с помощью продажи ссылок.

- Аффилирование - фильтр наказывает сайты, принадлежащие одному владельцу, которые продвигаются в смежных или одинаковых тематиках. На быструю руку фильтр определить достаточно сложно: на первой странице выдачи находится только один сайт, сайты день ото дня могут чередоваться, но вместе на первой странице не будут никогда.

- Фильтр за взрослый контент - применяется к сайтам, на которых присутствует (. Y .) либо ссылки и реклама на «взрослые» ресурсы.

- Фильтр за агрессивную рекламу – попадают сайты с попандерами, кликандерами, скрытыми редиректами. Последствие - понижение позиций в выдаче.

- Ссылочный взрыв – наказываются сайты, которые за маленький промежуток времени покупают большое количество ссылок. Результатом такого фильтра является зависание на определенных позициях без продвижения вверх.

- Фильтр за плохие ссылки - под этот фильтр Яндекса попадают сайты, которые пытаются продвигаться за счет некачественной ссылочной массы. Как итог, наблюдается резкое падение позиций в поисковой выдаче.

- Фильтр за накрутку поведенческих факторов - применяется к сайтам, которые замечены в искусственной накрутке поведенческих факторов.

- Минусинск – фильтр Яндекса за чрезмерное использование SEO-ссылок. Наказание – ограничение в ранжировании, т.е. вылет сайта на вторую-третью страницу.

Определяем возраст сайта

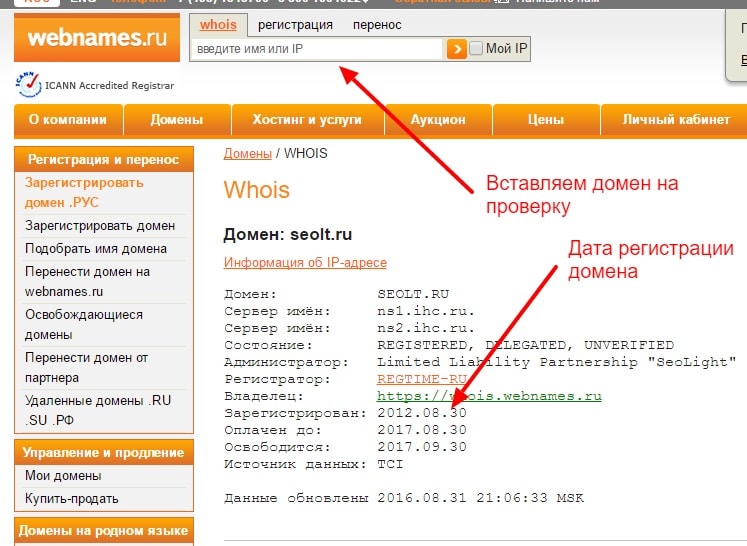

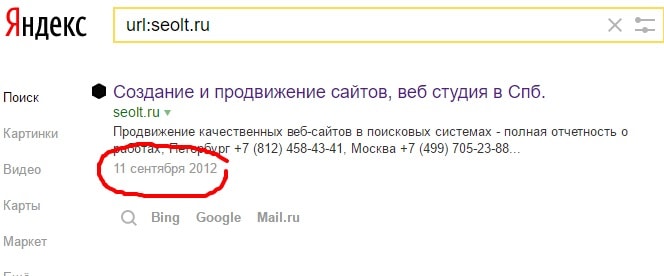

Довольно часто возникают сложности с определением истинного возраста сайта. Возраст домена можно определить в одном из сервисов whois, например, webnames.ru.

Для того, чтобы узнать фактическую первую дату индексирования главной страницы сайта Яндексом в том виде, в котором она находится сейчас, нужно вбить в адресную строку: http://yandex.ru/search/?text=url:seolt.ru&how=tm где seolt.ru - домен, проиндексированный Яндексом (важно понимать, что Яндекс может проиндексировать домен с www, тогда запрос изменится на https://yandex.ru/search/?text=url:www.seolt.ru&how=tm).

Показана первая фактическая дата индексирования главной страницы сайта в том виде, в котором она присутствует сейчас. Иногда внешний вид сайта компании меняется по нескольку раз и поэтому для получения верной информации о возрасте сайта приходится обращаться в archive.org/web/ - чтобы найти в индексе веб-архива первую версию сайта и понять сколько же ему в действительности лет.

Оцениваем трафик

Для определения посещаемости сайта можно воспользоваться сервисом similarweb.com и оценить следующие показатели:

- посещаемость (дневная и месячная);

- геолокация пользователей, то есть с каких стран идет трафик;

- доля платного и органического трафика;

- с каких сайтов идут посетители.

В основном Similarweb ориентирован на западный сегмент или на сайты, которые показывают значительные результаты по посещаемости. Определить «приблизительную» посещаемость сайта через сервис можно только при средней посещаемости - от 200-300 человек в сутки, если же она меньше, то данные будут неизвестны сервису.

Как быть, если количество трафика на сайт меньше? Очень просто, для таких сайтов используем megaindex.com (об этом сервисе чуть ниже).

Анализируем ссылочную массу

Для этого воспользуемся ресурсом ahrefs.com. Это инструмент анализа бэклинков, ведущих на сайт, с помощью которого анализируется ссылочная масса любых сайтов, определяются места ссылочных «взрывов». На основе полученных данных вырабатывается или совершенствуется своя стратегия наращивания внешних ссылок. С помощью графика роста/падения ссылок можно увидеть искусственный рост или экстремальное падение этих величин и понять - продвигали сайт или нет.

В заключение отдельно хочется отметить отечественный проект: megaindex.com - сервис, определяющий более точные данные по Рунету:

- количество трафика с поиска и рекламы (по каждой поисковой системе и региону);

- динамика и естественность ссылочной массы (продвигался ли сайт, если да, то насколько сильно);

- прогнозирование наложения фильтра «Минусинск» - как результат оценки соотношения естественных беклинков к коммерческим (при более 50% коммерческих ссылок возможно наложение фильтра).

Итак, подведем итоги анализа сайта «на коленке»

Если бегло взглянуть на сайт и пробежаться в течение 3 минут по различным сервисам, то можно определить:

- CMS – систему управления контентом сайта.

- Реальный возраст сайта – его первое вхождение в индекс поисковых систем.

- Количество и динамику трафика на сайт, его дифференциацию по регионам, поисковым системам и типу (платный / бесплатный).

- Текущие/будущие фильтры на сайте, и в особенности есть ли / будет ли «Минусинск».

- Количество SEO (коммерческих) ссылок на сайт, как вывод – продвигался ли сайт, продвигается ли сейчас или сайт «никто не трогал».